En 1982, Richard Feynman affirme qu’aucun ordinateur classique ne peut simuler efficacement la mécanique quantique. Cette déclaration modifie durablement la trajectoire de la recherche en informatique.

Les premiers résultats expérimentaux laissent entrevoir des capacités de calcul inaccessibles aux technologies traditionnelles. Les enjeux économiques, stratégiques et scientifiques s’alignent, accélérant la compétition mondiale autour de cette avancée.

L’informatique quantique, une révolution en marche

L’informatique quantique n’est plus un simple horizon théorique : elle s’impose déjà comme le ferment d’une rupture technologique majeure. C’est sur ce terrain que des mastodontes comme IBM, Google, Microsoft ou Intel rivalisent pour mettre la main sur le premier ordinateur quantique réellement opérationnel. Partout, des laboratoires publics, en France et ailleurs, s’engagent dans la quête acharnée du qubit performant.

L’ingrédient qui change tout ? La physique quantique, et son unité de base : le qubit. Contrairement au bit classique, condamné au choix binaire, le qubit s’autorise toutes les nuances d’états à la fois. Cette capacité à occuper plusieurs positions simultanément ouvre des perspectives radicales : les futurs calculateurs quantiques promettent d’affronter des défis inaccessibles aux architectures classiques et d’inventer des algorithmes jusqu’ici inimaginables.

La période actuelle, dite intermediate scale quantum, voit naître des prototypes équipés de dizaines à quelques centaines de qubits. Le quantique s’impose dans les stratégies nationales, bousculant la donne scientifique. Bâtir un ordinateur quantique universel est devenu l’ambition suprême.

Voici les grandes approches technologiques qui structurent la compétition :

- Processeurs à supraconducteurs : choix technologique de Google et IBM

- Qubits piégés par ions : une spécificité de plusieurs laboratoires européens

- Technologie silicium : la voie privilégiée par Intel pour industrialiser le quantique

L’écart entre ordinateurs quantiques et machines traditionnelles se creuse de jour en jour. En France, la mobilisation s’accélère à travers un plan national ambitieux et des moyens publics sans précédent. Dans l’ombre, la mutation vers l’ère informatique quantique se prépare : chercheurs, ingénieurs, industriels avancent, résolus à transformer les avancées théoriques en applications concrètes.

Qui sont les pionniers et quelles découvertes ont tout changé ?

L’histoire de l’informatique quantique s’est d’abord écrite à la marge, dans des universités de pointe et des laboratoires du CNRS ou du CEA. Un nom domine les débuts : Richard Feynman, physicien américain, qui, dès 1981 à Caltech, pose un jalon décisif. Selon lui, simuler la physique quantique avec un ordinateur classique relève de la chimère. C’est la porte d’accès à une nouvelle ère.

Dans la foulée, David Deutsch, à Oxford, formalise le concept d’ordinateur quantique universel. Il démontre qu’une machine exploitant la mécanique quantique pourrait rapidement dépasser toute limite du calcul traditionnel. L’idée, à la fois limpide et dérangeante, va bouleverser la discipline.

Parmi les figures qui ont fait basculer le domaine, on trouve :

- Peter Shor (MIT), qui, en 1994, conçoit l’algorithme de Shor : il révèle que la factorisation des grands nombres, pilier de la cryptographie, serait pulvérisée par un ordinateur quantique efficace.

- David Wineland (Nobel de physique 2012) et Serge Haroche (Collège de France) : leurs expériences sur les qubits, via des ions piégés ou des atomes dans des cavités résonantes, marquent le passage de la théorie à la démonstration tangible.

La France joue sa partition avec brio : des personnalités telles qu’Etienne Klein nourrissent la réflexion scientifique et le débat public. Des universités, du Canada à Paris, structurent un champ de recherche en perpétuelle ébullition. Guidés par leur intuition, ces pionniers ont redéfini les contours des sciences fondamentales et ouvert de nouveaux territoires à explorer.

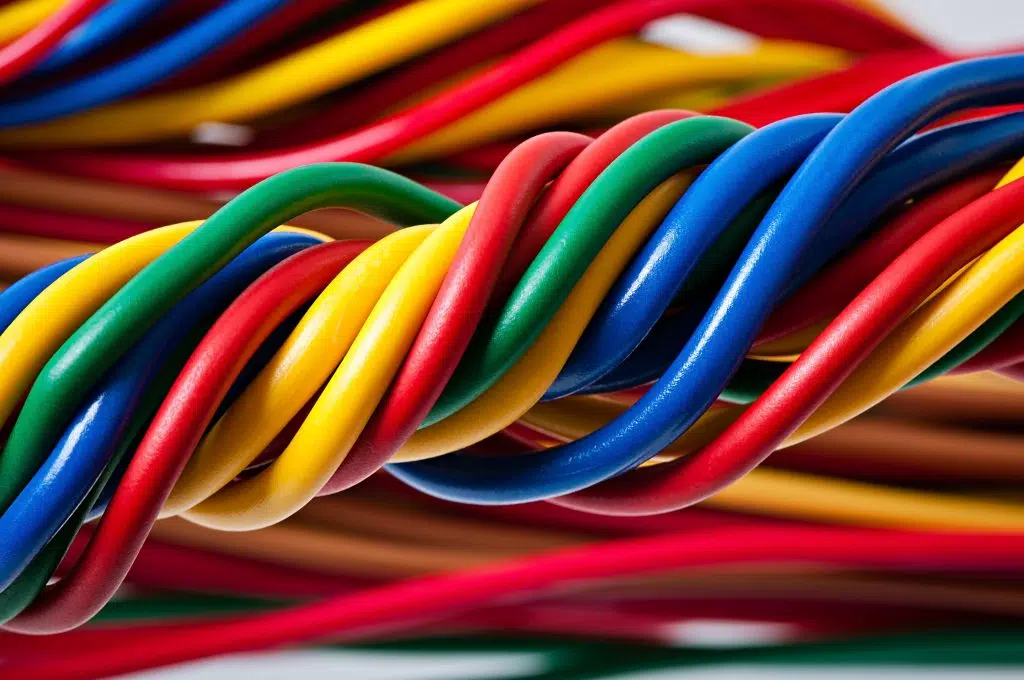

Comprendre les concepts clés : qubits, superposition et intrication expliqués simplement

Dans l’univers quantique, le qubit prend la place du bit classique. Plus de limite à la dualité 0/1 : grâce à la mécanique quantique, le qubit s’inscrit dans une superposition d’états, incarnant à la fois 0, 1, et toute combinaison possible entre les deux, pondérée par des nombres complexes.

La superposition change la donne. Avec seulement quelques qubits, un processeur quantique explore simultanément une multitude de solutions, là où un ordinateur classique doit procéder étape par étape. Cette capacité, ancrée dans les états quantiques, explique pourquoi les calculateurs quantiques suscitent autant d’espérances pour traiter des problèmes réputés inaccessibles.

L’intrication quantique ajoute une dimension encore plus singulière. Deux qubits intriqués deviennent inséparables : mesurer l’un, c’est instantanément affecter l’autre, même à des distances extrêmes. Cette connexion défie l’intuition classique et ouvre la voie à des protocoles de calcul ou de communication sans précédent.

Pour clarifier les intérêts de ces notions, voici leurs apports principaux :

- La superposition donne accès à une exploration parallèle des solutions.

- L’intrication permet d’inventer de nouvelles façons de transmettre et sécuriser l’information.

À la croisée de la physique et des mathématiques, ces concepts façonnent une architecture entièrement nouvelle pour l’ordinateur quantique. Et loin d’appartenir au mythe, ils alimentent déjà les premiers algorithmes quantiques testés en laboratoire.

Quels impacts attendre sur la société et les technologies de demain ?

Le calcul quantique s’annonce comme un accélérateur de mutations, bien au-delà de la simple question de puissance. Face à la déferlante des données, les ordinateurs quantiques pourraient décrypter des ensembles d’une ampleur inédite, révélant des corrélations que le calcul classique laisse dans l’ombre. On imagine déjà les retombées concrètes : optimisation logistique, modélisation accélérée de molécules pour l’industrie pharmaceutique, simulation de matériaux d’avant-garde… Les applications se dessinent dans tous les secteurs où la complexité est reine.

La cryptographie post-quantique cristallise bien des inquiétudes. L’algorithme de Shor, validé théoriquement, pourrait rendre obsolètes les systèmes actuels de sécurité numérique. Conséquence immédiate : autorités nationales et instances telles que le National Institute of Standards and Technology (NIST) multiplient les recherches pour bâtir des protocoles capables de résister à la puissance des machines quantiques.

Du côté des grands acteurs technologiques, la course au processeur quantique ne faiblit pas. IBM, Google, Microsoft, Amazon misent sur des alliances avec universités et centres de recherche pour développer des architectures hybrides, mariant qubits et circuits traditionnels. En France, le CNRS et le CEA entendent bien peser dans cette compétition de très haut niveau.

Quelques exemples de transformations attendues dans les années à venir :

- La data mining va connaître une mutation profonde, grâce à une capacité de traitement démultipliée.

- Les standards de sécurité devront être entièrement repensés, sous la pression de la cryptographie post-quantique.

- De nouveaux outils d’optimisation, applicables à l’industrie, l’énergie ou la recherche fondamentale, vont émerger.

Ce que prépare l’informatique quantique dépasse l’enjeu de la vitesse. C’est toute la cartographie des possibles qui se redessine, bousculant nos certitudes et posant de nouveaux défis éthiques, économiques et stratégiques. Une frontière s’ouvre, et le monde scientifique s’y jette, impatient de voir jusqu’où le quantique pourra nous mener.